La aceleración tecnológica, particularmente en el ámbito digital, constituye el principal driver de cambio para los futuros del trabajo. El avance de las tecnologías digitales comenzó alrededor de 1945, con el desarrollo de las primeras computadoras programables. Desde ese punto, la velocidad del progreso tecnológico ha sido asombrosa.

Un claro ejemplo de esta aceleración es que, a inicios de los años sesenta la NASA utilizó tecnología digital de punta para enviar a un hombre a la luna por primera vez en la historia. La computadora a bordo del célebre Apolo 11, nave con la que Neil Armstrong aterrizó en la superficie lunar, tenía 2 kB de memoria RAM y 32 kB de almacenamiento. Solo unas pocas décadas después, el poder computacional de un equipo celular Nokia (aquellos en los cuales jugábamos víbora) era cuatro mil veces superior. En 2024, un smartphone estándar ofrece unos 8GB de RAM y 128 GB de almacenamiento, es decir, unas cuatro millones de veces más en ambas categorías que la computadora del Apolo 11.

Esta progresión sigue la llamada Ley de Moore, una observación empírica que establece que el número de transistores en circuitos integrados se duplica cada 24 meses, mientras los costos se reducen a la mitad (Synopsys). Aunque esta ley no es científica, sino meramente empírica, demuestra una notable precisión durante seis décadas gracias a innovaciones en diseño y materiales (CSIS, 2022, Our World in Data, 2023).

El desarrollo de la Inteligencia Artificial (IA) ha supuesto una nueva etapa de aceleración en la capacidad de los sistemas digitales. La IA actual se basa principalmente en técnicas de aprendizaje automático (machine learning), donde los sistemas mejoran su desempeño mediante experiencia (datos), en lugar de programación explícita (Guo, 2017, Chen et al, 2023). En particular, el aprendizaje profundo (deep learning), basado en redes neuronales artificiales con múltiples capas, ha permitido que las máquinas capten patrones complejos sin intervención humana directa. Esto ha impulsado un incremento notable en las capacidades efectivas de las computadoras, acelerando aún más el ritmo del avance tecnológico (Muszynski, 2020, LSE Business Review, 2025).

El impacto de estos avances se hizo especialmente visible para el público general con el lanzamiento de ChatGPT en 2022, uno de los primeros Large Language Models (LLM). Los LLM como GPT-4 operan mediante aprendizaje autosupervisado, un método que permite que el sistema aprenda a predecir texto, sin necesidad de entrenamiento humano. Es decir, estos sistemas se enseñan a sí mismos.

Este enfoque optimiza una función de recompensa que maximiza la probabilidad de generar texto coherente, permitiendo que el sistema desarrolle habilidades avanzadas sin requerir programación explícita en cada tarea. Esta innovación ha permitido que el crecimiento en capacidades efectivas de estos modelos se acelere de forma aún más pronunciada (Xiong et al, 2024, Element451, 2025).

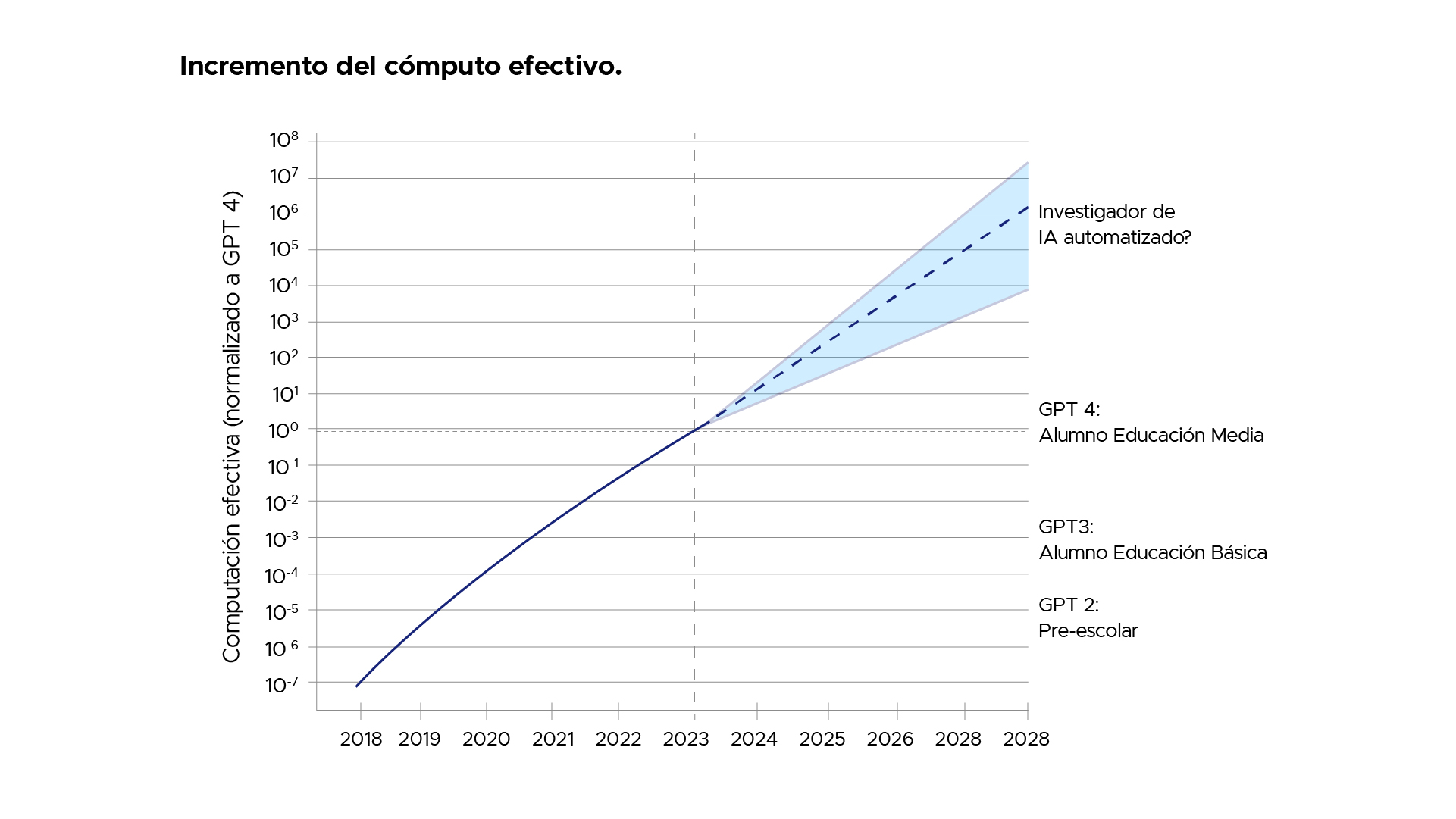

A medida que los modelos crecen en tamaño -empleando mayor cantidad de datos y poder de cómputo-se vuelven más capaces y cada vez más cercanos a las capacidades humanas. Por ejemplo, como muestra el siguiente gráfico, GPT-2 tenía un rendimiento comparable al de un niño en edad preescolar, mientras que GPT-3 alcanzó un nivel cercano al de un alumno de educación básica. GPT-4 fue capaz de exhibir habilidades académicas comparables a las de un estudiante de enseñanza media y, para 2025, ya existen modelos con la capacidad equivalente a la de un doctorado en áreas específicas. Esta progresión no muestra señales de desaceleración y muchos expertos estiman que este patrón se mantendrá en el futuro (Aschenbrenner, 2024).

Fuente: Aschenbrenner, 2024

En paralelo, el costo de utilizar estas tecnologías ha disminuido drásticamente. El entrenamiento de GPT-4 requirió aproximadamente 10²⁵ operaciones de coma flotante (FLOPs), lo que equivaldría a 3.000 años de cálculo en un solo GPU moderno. Sin embargo, nuevas técnicas permiten reutilizar aprendizajes previos, reduciendo significativamente los costos posteriores. De hecho, el costo se redujo 150 veces entre 2023 y 2024, superando ampliamente la tasa histórica prevista por la Ley de Moore.

Como era de esperar -debido a la obvia relación entre inteligencia y rentabilidad económica- esta aceleración de las capacidades de la IA ha impulsado una expansión masiva en infraestructura tecnológica.

Ejemplos destacados incluyen el proyecto Stargate en Estados Unidos, con una inversión de USD$500 mil millones en centros de datos con refrigeración líquida avanzada (Latitude Media, 2024). Por su parte, Meta ha comprometido USD$65 mil millones para instalar 1,3 millones de GPU a finales de 2025 (New York Times, 2025). En China, Alibaba Cloud ha anunciado una inversión de USD$52,4 mil millones para expandir su capacidad computacional hasta 2027 (South China Morning Post, 2025). En Europa se han destinado 109 mil millones de euros con el fin de reducir la dependencia tecnológica de EE.UU. y China; mientras que India ha puesto en marcha la «India AI Mission», que invertirá USD$1,2 mil millones en supercomputadores cuántico-híbridos (Fortune, 2025). En total, se estima que la expansión global de centros de datos para la IA requerirá más de 1 billón de dólares en inversiones durante esta década (McKinsey, 2024).

Como resultado, la demanda energética de estos centros de datos crecerá un 160% para 2030, alcanzando entre el 3% y el 4% del consumo energético global (Latitude Media, 2024, Goldman Sachs, 2024). Proyecciones para 2035 anticipan que esta proporción podría llegar al 25% del consumo total, evidenciando claramente la naturaleza de aceleración de las tecnologías digitales. Estos profundos cambios redefinirán los paradigmas productivos y laborales a una velocidad cada vez más rápida.